2025年11月21日、「心の声」をテキストに変換する「BIT(BraIn-to-Text)」が発表され話題を集めています。これは、まさに最新のニューラルネットワーク、ディープラーニングの応用例の一つです。

今回は、AIの進化を支えるニューラルネットワークについて、例を挙げながらわかりやすく解説します。ニューラルネットワークの基盤技術「重み付け」、ディープラーニングとの違いもお伝えするので、基礎からAIの仕組みを学びたい方はぜひ参考にしてください。

ニューラルネットワークとは?

ニューラルネットワークとは、人間の脳神経回路を模倣して作られたAIの中枢技術です。ニューラルは「神経(ニューロン)」を意味し、生物の神経回路と区別するときは「人工ニューラルネットワーク」と呼ばれます。

人間の脳の情報伝達の流れ

人間の脳内では、以下のような流れで情報伝達が絶えず繰り返されています。

- 樹状突起が他の細胞から信号を受け取る

- 細胞内部で処理

- 軸索を通して次のニューロン(樹状突起)へ伝達

この軸索と樹状突起が接続する部分が「シナプス」です。

シナプスは、重要な情報に対応するほど結合が強まり、重要性の低い情報に対応するほど弱まります。

「シナプスの可塑性」が生む知能

このように、結合の強さが変化する性質を「シナプスの可塑性」と呼びます。人間はこの可塑性があるからこそ、名前を覚え、計算が速くなり、逆に昨日見た車のナンバーは忘れる、のように自然と学習を効率化しているのです。

人工ニューラルネットワークでは、この接続の強さを「重み(W)」として数値化し、シナプスの可塑性と同じように学習データに応じて重みを調整し、学習精度を高めています。

こうしたニューラルネットワークの基本的な仕組みを理解できると、AIの最新技術である画像認識や生成AIなどの仕組みも一気にわかりやすくなります。

G検定では、まさにこの基礎となる知識が問われます。「短期間で効率よく理解したい」という方は、要点を効率的に学べるG検定対策講座がおすすめです。

ニューラルネットワークの基本構造

続いて、ニューラルネットワークの基本構造について解説します。

続いて、ニューラルネットワークの基本構造について解説します。

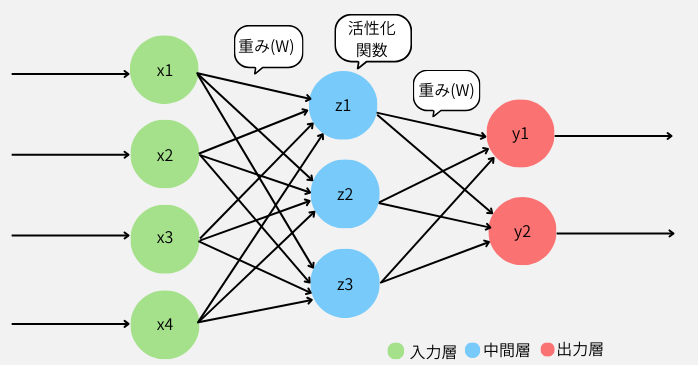

3つの層の役割

ニューラルネットワークは、情報の処理を行うために、主に3つの役割を持った層で構成されています。まずは、各層の役割を表でご確認ください。

| 層の種類 | 主な内容 |

| 入力層 |

|

| 中間層(隠れ層) |

|

| 出力層 |

|

データの流れの例

続いて、画像認識を例に、ニューラルネットワークのデータの流れをステップごとに見てみましょう。ここでは、AIが「犬、猫、魚」の内、「魚」を判別する例を挙げて解説します。

- 魚の画像を、コンピューターが扱える数値のデータに変換

- 写真の画像を細かくマス目状に区切る

- 入力層で各マスの色の濃淡を、すべて数字に変換(明→0.9、暗→0.2など)

- 中間層で重み付けをして、魚の特徴を抽出する演算を実施

- 出力層で数字(最終判断)が出力

この出力された数字は、ニューラルネットワークが判断した「犬」「猫」「魚」それぞれの選択肢に対する回答(スコア)です。

出力層では「確率」の算出後に「誤差」を計算する

ニューラルネットワークの出力層で得られる値(AIの最終判断)は、確率や予測値として表されます。例えば先ほどの例なら、「犬20%・猫20%・魚60%」のように分類ごとの確率が並びます。

しかし、AIがより正確な判断ができるようになるには、正解データ(教師データ)と照らし合わせて、どれだけズレていたかを測る必要があります。このズレを数値化したものが「誤差関数」です。

誤差関数は、予測と正解の差が大きいほど値も大きくなるのが特徴で、代表的なものに以下があります。

- 平均二乗誤差(MSE)

- 平均絶対誤差(MAE)

ニューラルネットワークは、この誤差をできるだけ小さくするように、中間層の「重み」を調整しながら学習を進めていきます。次項では、この「重み付け」について解説しましょう。

ニューラルネットワークで情報を伝える「重み付け」

では、ニューラルネットワークの「重み付け」について解説しましょう。

中間層で情報の重要度を調整する「重み」

ニューラルネットワークの中間層では、前の層から受け取った情報を次の層に送る際に、その情報の重要度を調整します。この調整を行う数値が「重み」です。すでに触れたとおり、重みとは各接続(結合)がどれだけ重要かを表す値です。

例えば、AIにとって非常に重要な特徴であれば「10倍」、あまり重要でなければ「0.1倍」というように、ニューラルネットワークの「重み」は情報の強さを柔軟に調整します。

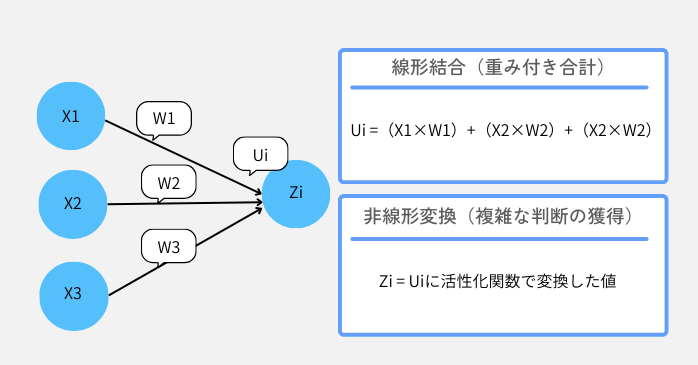

重み付けの合計(線形結合)と活性化関数の役割

上記画像の様に、ニューラルネットワークの入力層にある「X1、X2、X3」は、それぞれに「重み(W)」が掛けられ、重要度が調整された値になります。そして、それらを全部足し合わせた結果が「Ui」です。

Ui =(X1×W1)+ (X2×W2)+(X3×W3)

しかし、「Ui」は、足し算の結果でしかなく、AIが複雑な判断をするには不十分です。そこで「Ui」を活性化関数に通して、より良い判断ができる形に変換します。この、変換後の値が「Zi」です。

Zi = Uiを活性化関数で変換した値

このように、ニューラルネットワークにおいて、次の層へ情報を送る際には、この「重み付きの合計(線形結合)」と「活性化関数による変換」の二段階の処理が必ず行われます。

ニューラルネットワークで活性化関数が必要な理由

続いて、ニューラルネットワークの計算で、なぜ活性化関数が必要なのかについて解説します。

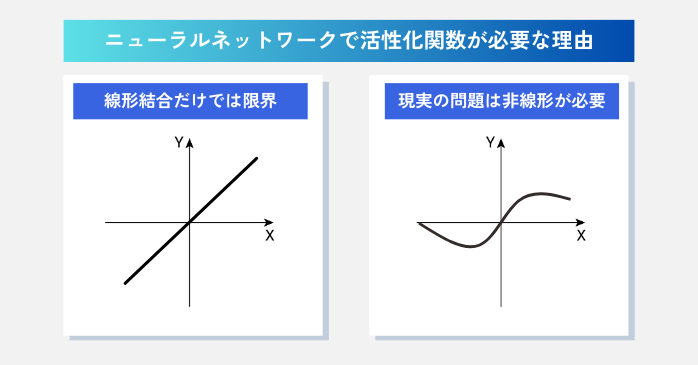

線形結合(重み付きの合計)だけでは限界

ニューラルネットワークで活性化関数が必要なのは、線形結合(重み付きの合計)だけでは判断力に限界があるためです。「重み付きの合計」(Uiを求める計算)は、数学でいう一次関数(直線)と同じ性質を持っています。

しかし、一次関数のニューラルネットワークは、一本の直線で表せるような単純な判断しかできません。例えば、「70点以上は合格、以下は不合格」のように、境界が真っすぐな問題しか扱えないのです。

現実の問題は非線形が必要

とはいえ、実際の画像認識のような問題はもっと複雑です。例えば、「猫の画像」を判断するには、毛や耳の形、ヒゲの有無など、多くの特徴が絡み合った状況(非線形パターン)で判別する必要があります。

しかし、一次関数のニューラルネットワークでは、このような複雑なパターンを表現できず、層をいくつも重ねても直線的な判断しかできません。そこで活性化関数で「Ui」を「Zi(非線形の情報)」に変換し、柔軟かつ高度な判断ができるようにします。

ニューラルネットワークで使われている活性化関数

ニューラルネットワークで使われる活性化関数に求められるのは、必要な情報と不要な情報を分けること、学習に必要な微分の可能性があることです。その要件を満たした3つの活性化関数を見てみましょう。

| 種類 | 主な特徴 |

| シグモイド関数 |

|

| 双曲線正接関数 |

|

| 正規化線形関数 |

|

シグモイド関数、双曲線正接関数、正規化線形関数の3つは、ニューラルネットワークの進化の歴史を象徴する代表的な関数です。

シグモイド関数と双曲線正接関数は、ニューラルネットワークの初期から使われてきた古典的な関数であり、基礎的な理論の確立に貢献しました。正規化線形関数は、その計算速度の速さから近年のディープラーニングの発展を大きく加速させ、現在では最も主流な関数となっています。

ニューラルネットワークとディープラーニングとの違い

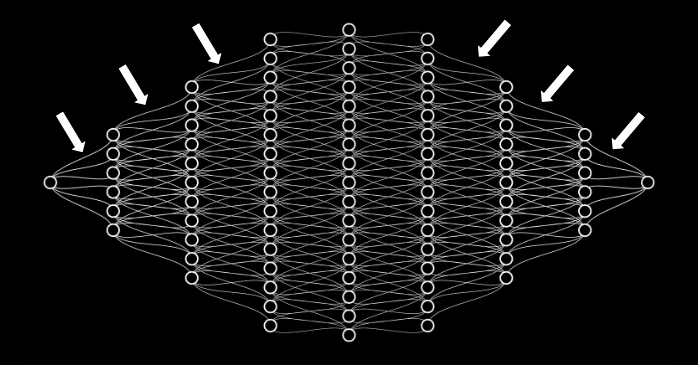

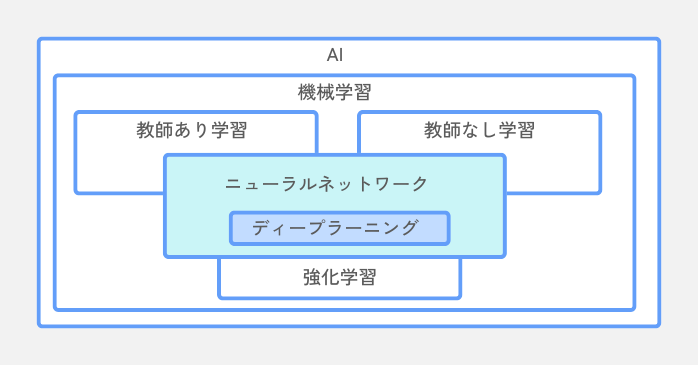

「ニューラルネットワークとディープラーニングは何が違う?」と疑問を持つ方は多いですが、実は比較の対象ではありません。ディープラーニングは、ニューラルネットワークをより深く発展させた方式の一つです。

ここでは、ディープラーニングの定義、目的、課題点を見てみましょう。

ディープラーニングとは?

ディープラーニング(深層学習)は、中間層を多層化(2層以上)したニューラルネットワークの構造(モデル) のことです。層を深くすることで、データ内に隠れた複雑なパターンや特徴を学習し、より複雑な問題に対応できるようになります。

機械学習は「教師あり・教師なし・強化学習」に分類され、その中で使われる代表的な技術がニューラルネットワークです。そして、このニューラルネットワークを発展させたものがディープラーニングで、現代の画像認識や音声認識といったAIの高性能化を支えています。

機械学習の一つ「強化学習」には、二つの学習を同時進行で行える「マルチタスク学習」があります。自動運転の「車線維持」と「障害物回避」という二つの操作を同時に行うのもマルチタスク学習によるものです。

詳しくは以下の記事で解説していますので、こちらもぜひご一読ください。

ディープラーニングの目標

ディープラーニングの主な目標は、より正確な判断を下せる「関数」を作り上げることです。ニューラルネットワーク内で行われる入力から出力までの一連の計算は、「一つの大きな関数」と見なせます。

ニューラルネットワークでは、その関数を最適化(=重みを調整)すれば、最も良い結果(高い精度や正確な予測)が得られます。つまり、この「最適化された関数」を生み出すのがディープラーニングの目標なのです。

ディープラーニングの課題

ディープラーニングは、ニューラルネットワークの中間層を増やして回答の精度を高めますが、中間層を増やすことで、以下のような課題点も生じます。

| 課題点 | 概要 |

| 過学習 | 練習用データにだけ特化してしまい、実践では正しく判断できなくなる |

| 中間層の数 | 中間層は増えると重み(パラメータ)が爆発的に増え、実用的でなくなる |

| 計算負荷の増大 | 大規模になるほど計算コストが上がり、最適化が難しくなる |

このように、ニューラルネットワークのディープラーニングは「複雑な関数を作れる」という強みを持つ一方で、過学習や計算量の増加といった課題も抱えています。

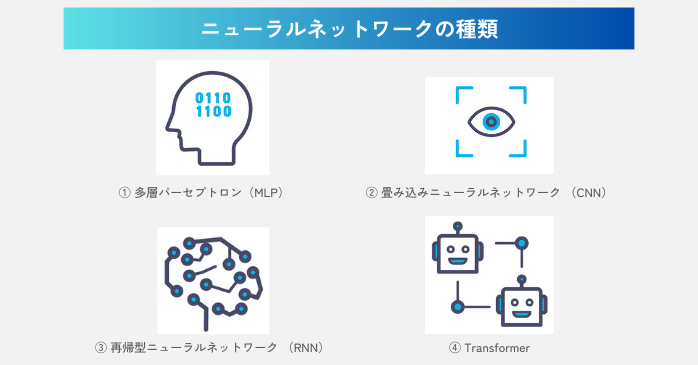

ニューラルネットワークの種類

ニューラルネットワークは、情報の流れ方や層の結合様式によって様々な種類があります。ここでは、ニューラルネットワークの種類を紹介しましょう。

主なニューラルネットワークの種類

はじめに、ニューラルネットワークを代表する4つの種類をご紹介します。

| 分類 | モデル名 | 概要 | 主な用途 |

| 順伝播型 (FFN) |

多層パーセプトロン (MLP) |

|

|

| 畳み込みニューラルネットワーク (CNN) |

|

|

|

| 回帰型 (RNN) |

再帰型ニューラルネットワーク (RNN) |

|

|

| その他 | Transformer |

|

|

その他にも、確率的な動作を取り入れた「確率的ニューラルネット」、リアルな画像などを生成する敵対的生成ネットワーク(GAN)など、ニューラルネットワークには多様なモデルが存在します。

畳み込みニューラルネットワーク

続いて、上記の中で注目度の高い畳み込みニューラルネットワーク(CNN)について解説します。

畳み込みニューラルネットワークの仕組み

畳み込みニューラルネットワーク(CNN)は、近年の画像認識や画像生成ブームを支える中心的なモデルです。その主な仕組みは、

- 畳み込み層(輪郭・模様・色の変化など、画像の特徴を抽出)

- プーリング層(抽出した特徴を圧縮、最適化)

- 全結合層(最終的な分類や予測を実施)

の3ステップで成り立っています。これらを組み合わせることで、画像の局所的な特徴を効率よく学習できるのが特長です。

畳み込みニューラルネットワークの活用分野

畳み込みニューラルネットワークの応用範囲は広く、私たちの身近な分野で活用されています。

- 自動運転(道路標識・歩行者の検出)

- 医療画像診断(腫瘍の発見など)

- 監視カメラ映像の解析

- 製造業の外観検査(傷・欠陥の自動検出)

このように多様な業界で活用が広がる中、ニューラルネットワークの理解はもちろん、AI技術を扱える人材の重要性はますます高まっています。

ニューラルネットワークの学習はG検定からはじめよう!

G検定は、ニューラルネットワークをはじめとしたAI全般の知識を問われるため、AI人材の入門スキルとして最適です。

G検定は、ニューラルネットワークをはじめとしたAI全般の知識を問われるため、AI人材の入門スキルとして最適です。

「独学では学習時間が確保しにくい」「効率よく要点だけ身につけたい」という方は、短期間で基礎をまとめて学べるG検定対策講座を活用するのも効果的です。学習方法の自由度も高いため、無理なく継続しながらG検定取得を目指せます。

セミナー名 G検定対策講座 運営元 GETT Proskill(ゲット プロスキル) 価格(税込) 0円(無料キャンペーン中) 開催期間 1日間 受講形式 対面(東京)・ライブウェビナー・eラーニング

ニューラルネットワークについてまとめ

ニューラルネットワークは、人間の脳の仕組みを参考に作られたAI技術で、学習データに応じて「重み」を調整することで精度を高めています。

今回扱ったニューラルネットワークの内容はAIの基礎として非常に重要で、ここを理解しておくことで生成AIやデータ分析など、より高度な領域にもスムーズに進めます。ニューラルネットワークの理解をさらに体系的に深めたい方は、G検定でその知識を確かな形にしましょう。